有关这块,还有一些相关的paper,后续可以读一读:

以下是几篇关键论文,从不同角度解释了为何Transformer模型采用多头注意力(Multi-Head Attention, MHA)机制,以及其优势与必要性:

1. **原始Transformer论文

- 核心观点:

Vaswani等人在2017年的开创性论文中首次提出MHA,认为并行化多个独立注意力头可以增强模型对不同子空间特征的捕捉能力。每个头通过独立的线性变换生成查询(Q)、键(K)、值(V),允许模型从多个角度关注输入的不同语义或语法模式(如局部依赖、长程关联等)。 - 实验验证:

在机器翻译任务中,多头注意力显著优于单头,验证了多视角学习的有效性。例如,8头注意力在WMT 2014英德翻译任务中BLEU得分提升约2点。

2. **Collaborative Multi-Head Attention (2020)

- 核心发现:

该论文指出,传统MHA中不同头的键/查询(QK)投影存在冗余,通过共享部分投影参数(如QK投影的公共子空间),可以在保持性能的同时减少参数量的25%-50%。这表明多头设计虽然冗余,但通过参数共享仍能高效捕捉多样性特征。 - 意义:

即使存在冗余,多头的并行学习能力仍是其核心优势,冗余可能为模型提供鲁棒性。

3. **《Are Sixteen Heads Really Better Than One?》(Michel et al., 2019)

- 核心分析:

研究发现,多数注意力头在训练后功能冗余,某些头甚至可被剪枝而不影响性能。然而,保留多个头的原因在于:- 动态任务需求:不同任务或输入需要不同头的组合;

- 训练稳定性:冗余头在训练初期提供多样化的梯度信号,避免优化陷入局部极小。

- 结论:

多头设计是一种“过参数化”策略,通过冗余提升泛化能力,而非单纯增加表达能力。

4. **《MoH: Multi-Head Attention as Mixture-of-Head Attention》(2024)

- 创新视角:

该论文将MHA与混合专家(MoE)结合,提出动态路由机制(MoH),允许每个token选择Top-K相关头。实验表明,动态选择头可减少50%-90%的计算量,同时提升性能(如LLaMA3-8B准确率提升2.4%)。 - 对MHA的解释:

传统MHA的固定头分配限制了灵活性,而动态路由验证了多头价值的本质在于特征的多样性,而非固定数量的头。

5. **《DCMHA: Dynamically Composable Multi-Head Attention》(2024)

- 结构分析:

该工作解耦MHA中的QK(查找回路)和OV(变换回路),允许动态组合不同头的QK与OV,形成多达H²个“虚拟头”。实验显示,DCMHA模型(如DCPythia-6.9B)性能超越传统Transformer模型(如Pythia-12B),说明传统MHA通过固定组合限制了表达能力,而动态解耦释放了多头的潜力。 - 意义:

MHA的设计初衷是通过多组独立参数捕捉多样性,但动态组合进一步验证了其底层逻辑的合理性。

6. **多头注意力的理论分析

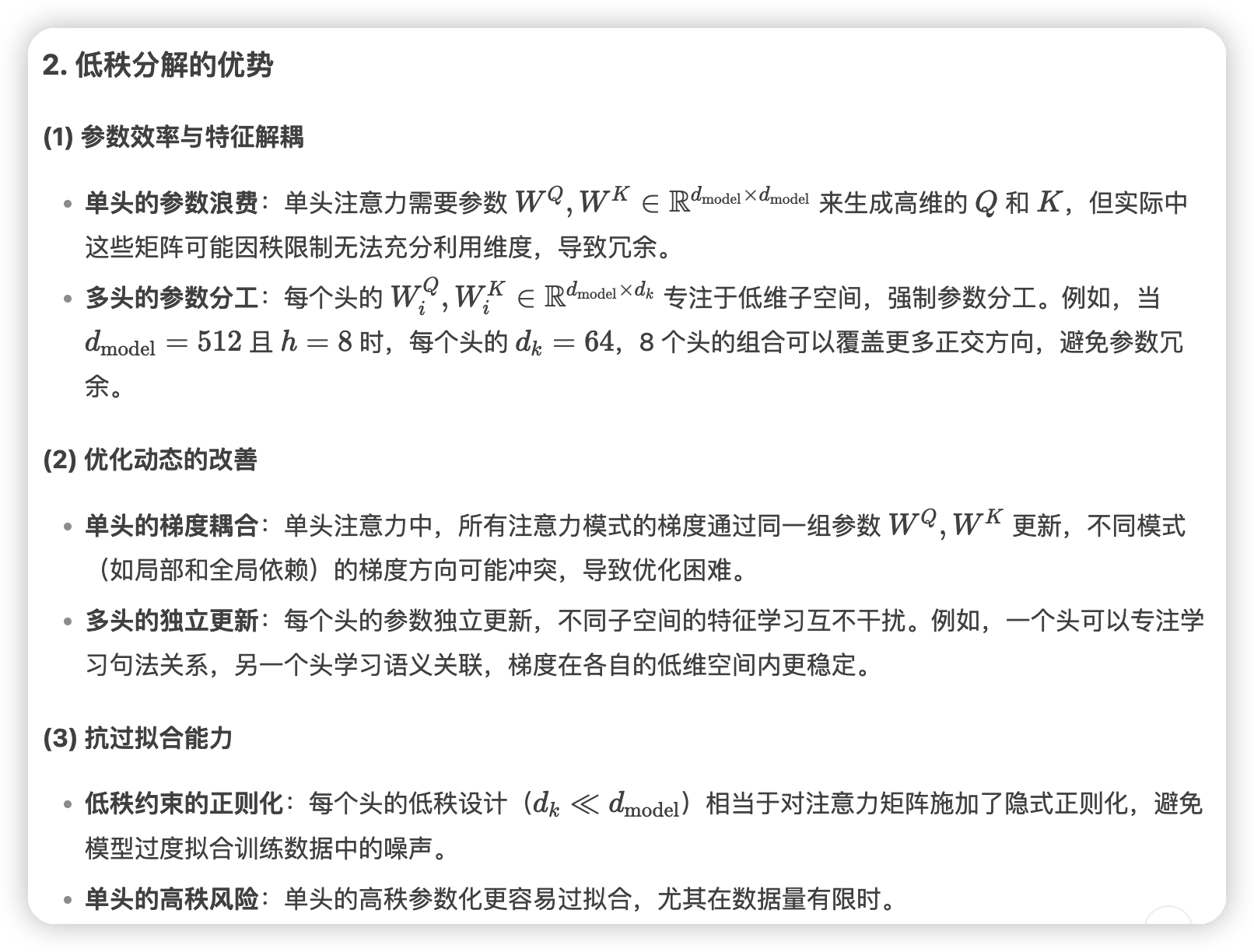

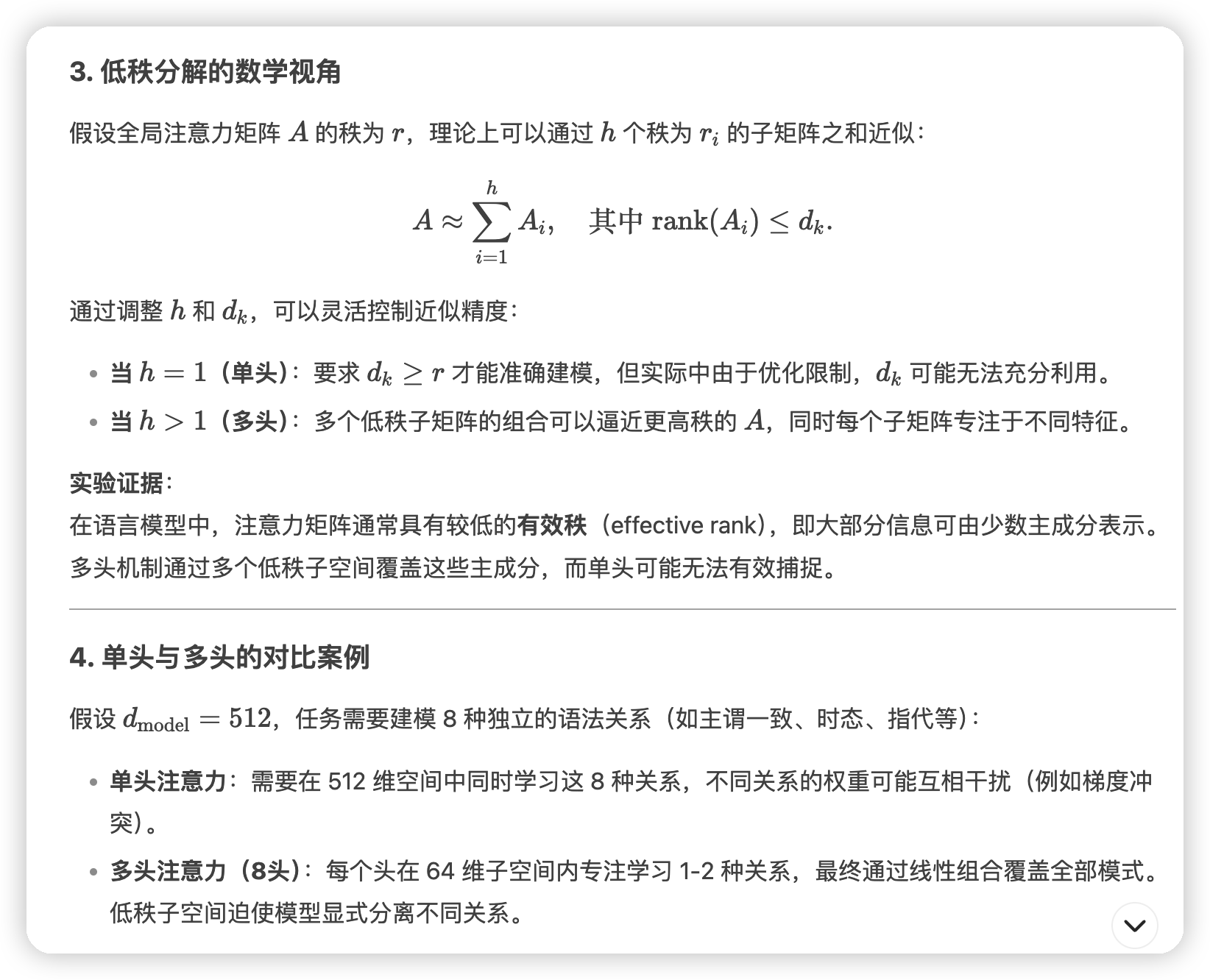

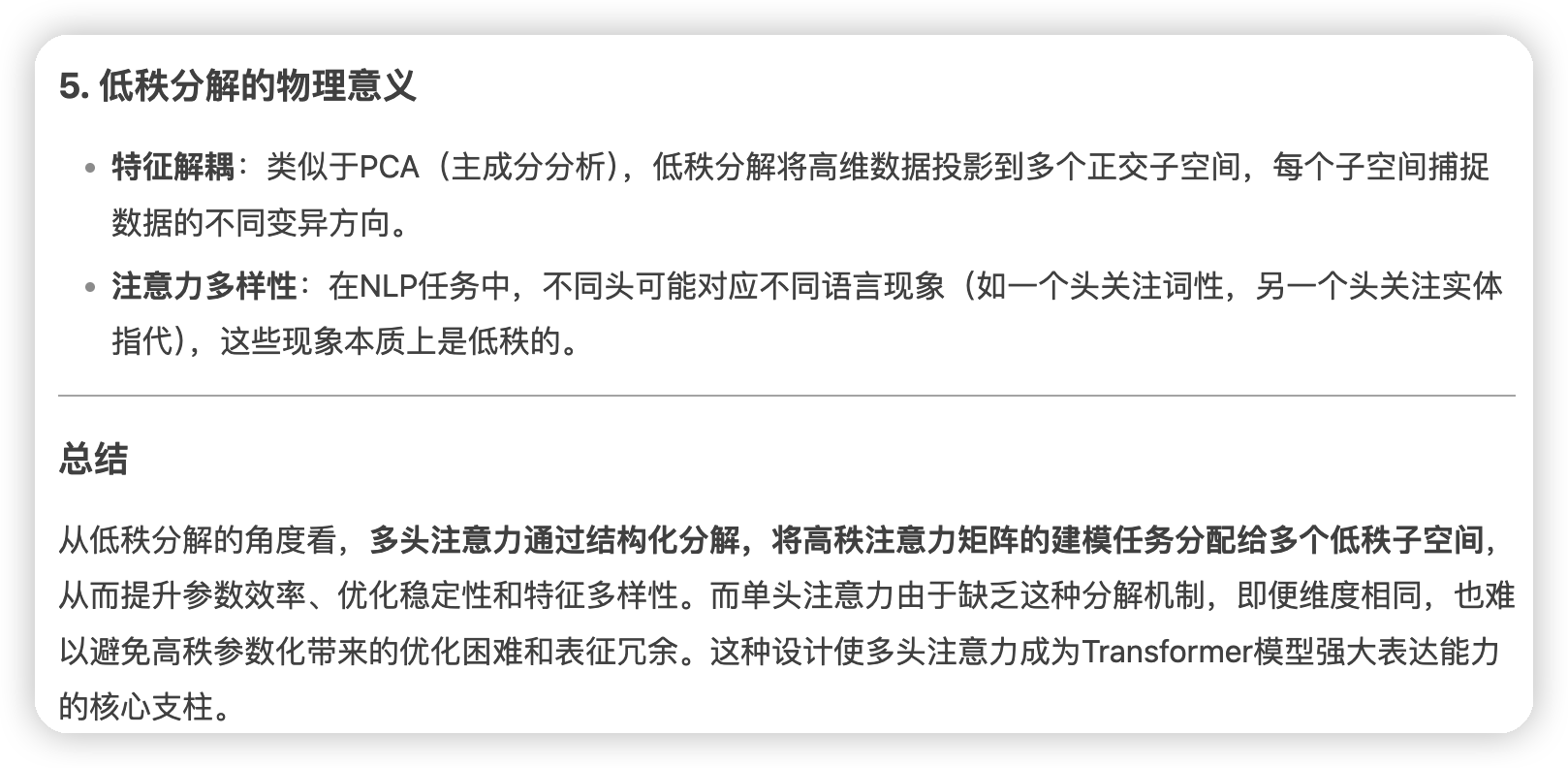

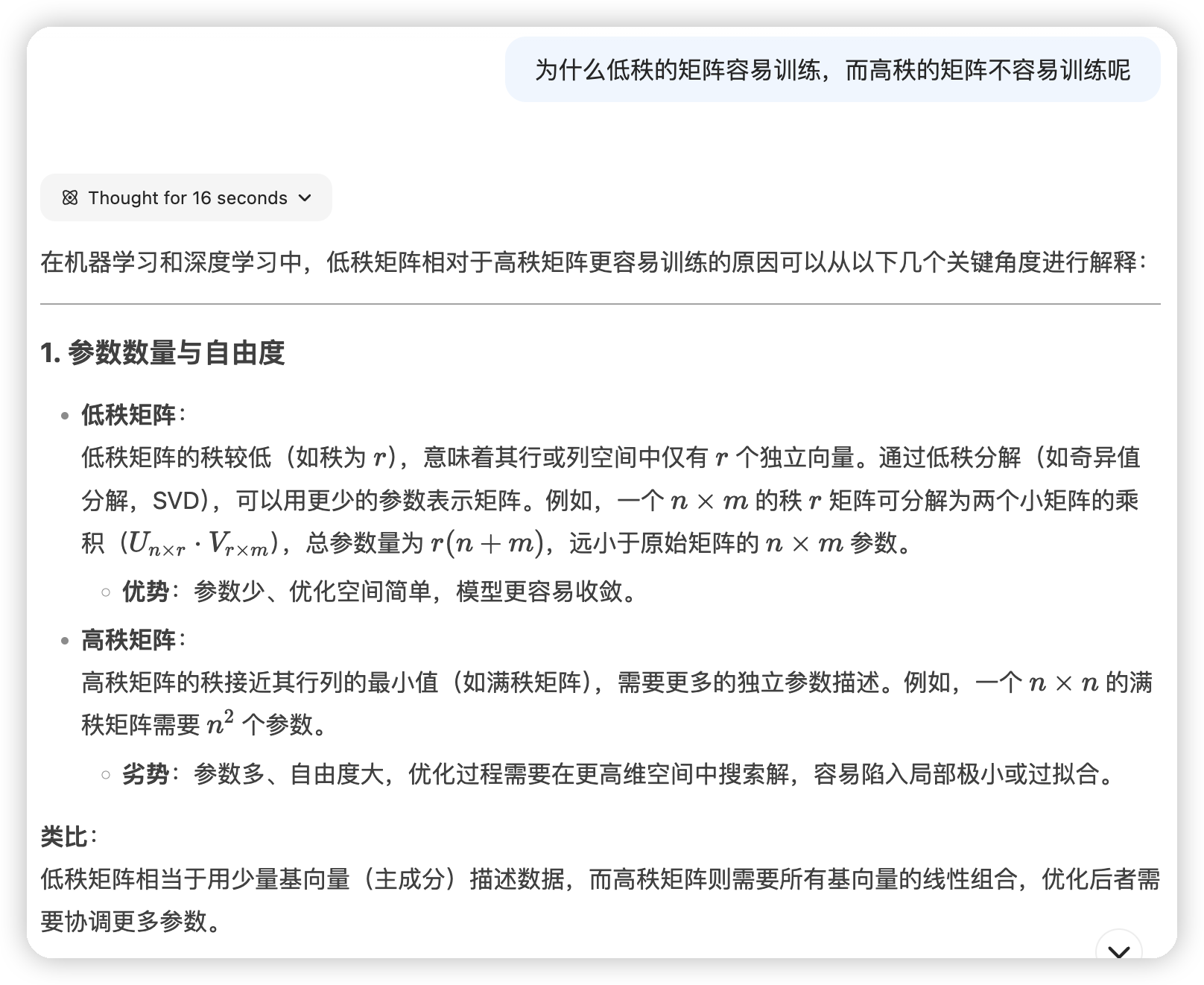

- 子空间解耦与低秩性:

研究指出,MHA通过将输入投影到多个低维子空间(每个头维度为d_model/h),实现了对高维注意力矩阵的低秩分解。这种分解既降低了计算复杂度,又通过组合多个低秩子矩阵逼近高秩全局特征,从而增强表达能力。 - 功能分工:

可视化分析表明,不同头可能隐式学习不同功能(如句法解析、指代消解),多头的协作提升了模型对复杂模式的综合处理能力。

总结与前沿方向

当前研究普遍认为,MHA的核心优势在于:

1. 多样性特征捕捉:通过并行子空间学习不同模式;

2. 鲁棒性与泛化:冗余设计提供训练稳定性与任务适应性;

3. 结构扩展性:支持动态优化(如MoH、DCMHA)以进一步提升效率。

未来方向可能聚焦于动态路由(如MoH)、低秩优化(如DCMHA)及可解释性分析(如头功能可视化),以更高效地利用多头机制。

文章评论