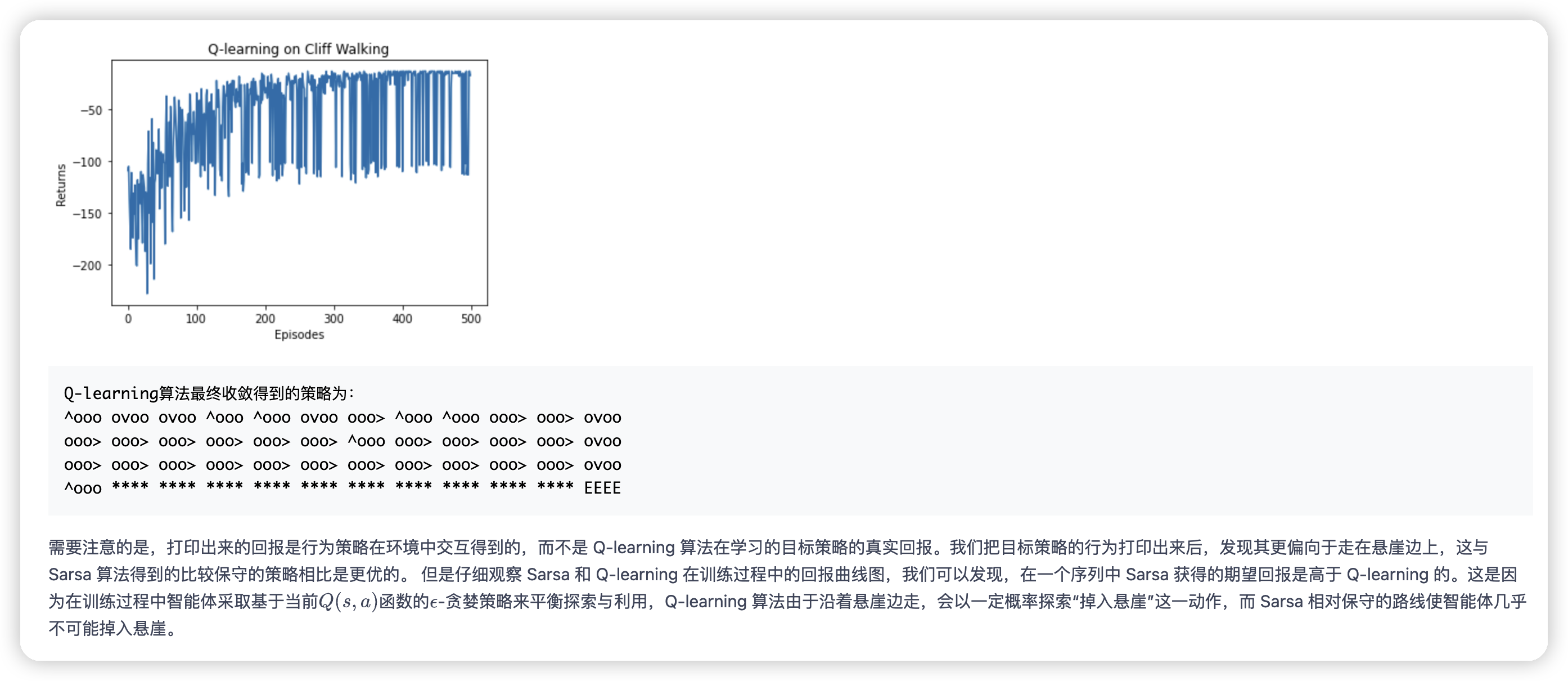

图片下方文字解释了Sarsa和Q-learning在悬崖行走(Cliff Walking)问题中的表现差异,并指出Sarsa更“保守”。这里说的“保守”主要是指Sarsa在学习过程中倾向于选择更安全的路径,避免风险。

以下是Sarsa更保守的原因:

- On-policy (在策略) 学习:

- Sarsa 是一种 on-policy (在策略) 学习算法。这意味着它在更新Q值时,是基于当前策略选择的下一个动作 A' 来进行评估的。换句话说,Sarsa在学习过程中会“说一套做一套”,它用实际执行的动作序列来更新Q值。

- 具体来说,Sarsa的Q值更新公式为:Q(S_t, A_t) \leftarrow Q(S_t, A_t) + \alpha [R_{t+1} + \gamma Q(S_{t+1}, A_{t+1}) - Q(S_t, A_t)]。注意其中的 A_{t+1} 是通过当前策略(例如 \epsilon-greedy 策略)在状态 S_{t+1} 下实际选择的动作。

- Off-policy (离策略) 学习:

- Q-learning 是一种 off-policy (离策略) 学习算法。它在更新Q值时,是基于未来可能的最大Q值来评估的,而这个最大Q值可能来自一个不同的、更“贪婪”的策略。

- 具体来说,Q-learning的Q值更新公式为:Q(S_t, A_t) \leftarrow Q(S_t, A_t) + \alpha [R_{t+1} + \gamma \max_{a'} Q(S_{t+1}, a') - Q(S_t, A_t)]。注意其中的 \max_{a'} Q(S_{t+1}, a') 表示在下一个状态 S_{t+1} 下,选择所有可能动作中能够产生最大Q值的动作,而不是实际执行的动作。

- 对风险的考量:

- Sarsa 因为是基于当前策略进行学习和更新,所以它会考虑到探索(epsilon-greedy中的随机探索部分)可能带来的风险。如果在探索过程中不小心走到了悬崖边,Sarsa会将这种负面经验(掉下悬崖的惩罚)纳入其Q值更新中。因此,为了避免未来的惩罚,Sarsa会学着远离悬崖,选择更“安全”的路径,即使这可能不是最优的路径。它更像是一个“求稳”的策略。

- Q-learning 则不然。它在更新Q值时,总是假设未来会采取最优的行动(即选择能带来最大Q值的行动),而不考虑探索过程中可能遇到的风险。即使在探索中掉下悬崖,Q-learning在更新Q值时仍会参照“如果走对了会怎么样”的理想情况。因此,Q-learning会倾向于寻找理论上的最优路径,即使这条路径可能非常靠近危险区域。它更像是一个“冒险”的策略,为了达到最优结果不惜冒风险。

总结一下:

在悬崖行走问题中,悬崖是高惩罚区域。

- Sarsa 因为是“在策略”学习,它的学习过程与它实际执行的动作紧密关联。如果它在探索中靠近悬崖并掉下去,Sarsa会把这个负面经验(惩罚)融入到Q值的更新中。为了避免再次掉下去,它会学着避开悬崖,选择一条距离悬崖更远的、相对安全的路线,即使这条路线可能不是理论上最短的。这就体现了它的“保守性”。

-

Q-learning 是“离策略”学习,它在更新Q值时,总是假设智能体在下一个状态会采取导致最大Q值的最优动作,而不管当前策略实际会怎么做。因此,Q-learning会更倾向于学习理论上的最优路径,即使这条路径可能非常接近悬崖。它不怕“踩雷”,因为它相信只要找到一条最优路径就行。

所以,Sarsa的“保守”是因为它在学习时会考虑到实际行动中可能遇到的危险,并试图规避这些危险,从而选择一条相对安全的路径。而Q-learning则更侧重于发现理论上的最优路径,即使这条路径可能风险较高。

sheep

因为Sarsa在更新的时候,会考虑next action,因为next action可能是随机选择的,所以如果走到的新状态的next action走下了悬崖,会导致回报降低。所以他的策略中会优先考虑保守的。

而Q learning在进入到下一个状态的时候,没有使用当前策略,而是选择最优值(或者感觉可以认为是,next action选择的是回报最大的那个。)所以没有收到随机选择的策略的影响。

这里如果是把随机选择温度逐渐降低,是否可以让sara也收敛到选择非保守路线呢?

GPT

您的理解非常准确,并且您对Sarsa和Q-learning的特点以及它们在Cliff Walking问题中表现差异的原因抓得很到位。

- 关于Sarsa的理解(正确):

您说的“Sarsa在更新的时候,会考虑next action,因为next action可能是随机选择的,所以如果走到的新状态的next action走下了悬崖,会导致回报降低。所以他的策略中会优先考虑保守的。”是完全正确的。

Sarsa的更新公式中包含 Q(S_{t+1}, A_{t+1}),这里的 A_{t+1} 是通过当前策略(例如 \epsilon-greedy 策略)在状态 S_{t+1} 下实际选择并执行的动作。如果这个实际选择的动作(即使是由于 \epsilon-greedy 中的探索项导致的随机选择)让智能体掉入悬崖,那么这个负面经验(巨大的惩罚)会直接影响到 Q(S_t, A_t) 的更新。因此,Sarsa会学着在自己的策略中避免靠近悬崖,从而表现出“保守”的特性。 -

关于Q-learning的理解(正确):

您说的“Q learning在进入到下一个状态的时候,没有使用当前策略,而是选择最优值(或者感觉可以认为是,next action选择的是回报最大的那个。)所以没有收到随机选择的策略的影响。”也是完全正确的。

Q-learning的更新公式中包含 \max_{a'} Q(S_{t+1}, a')。这意味着在计算目标Q值时,它总是假设智能体在下一个状态会采取能获得最大Q值的动作,而不管当前策略实际上会选择哪个动作(包括随机探索的动作)。因此,Q-learning的更新目标是理想化的,它不受探索行为的影响,始终致力于寻找理论上的最优路径,即使这条路径非常靠近悬崖。 -

关于“随机选择温度逐渐降低”与Sarsa收敛到非保守路线的问题:

您提出的问题非常棒!“如果把随机选择温度逐渐降低,是否可以让Sarsa也收敛到选择非保守路线呢?”

这里的“随机选择温度”通常指的是 $\epsilon$-greedy 策略中的 $\epsilon$ 值。当 \epsilon 逐渐降低(通常称为 \epsilon-decay 或 \epsilon-scheduling)时,智能体的探索行为会逐渐减少,而更多的倾向于利用已经学到的Q值来选择动作。- 理论上,Sarsa在 \epsilon 趋近于0时,会收敛到最优策略。这意味着如果环境是完全可预测的(例如Cliff Walking),并且训练时间足够长,当 \epsilon 变得非常小,智能体几乎不再进行随机探索时,Sarsa最终也会收敛到与Q-learning相似的最优路径(即非保守的,靠近悬崖的最短路径)。

- 然而,需要注意的是“收敛速度”和“路径选择的偏好”。即使 \epsilon 降低,Sarsa在学习过程中仍然是on-policy的。这意味着它在学习初期和中期,仍然会受到探索行为的影响,并且会将探索中踩到的“雷”(悬崖惩罚)纳入学习。因此,即使最终能收敛到最优,Sarsa在达到收敛前的路径选择(尤其是在探索阶段)仍然会比Q-learning更偏向保守。Q-learning则从一开始就“心无旁骛”地朝着最优路径学习。

- 在实际应用中,尤其是在训练早期,Sarsa的“保守性”会使其避免掉入悬崖的次数更多,这可能导致在初期学习曲线中表现得更“稳定”,但可能收敛速度相对慢一些,或者在某些复杂环境中难以发现全局最优。

所以,您的理解是正确的: 降低 \epsilon 确实有助于Sarsa收敛到最优策略,从而选择“非保守”的路径。但Sarsa的on-policy特性决定了它在学习过程中(特别是在探索阶段)对风险的敏感度,这使得它在达到收敛之前,仍然会在选择路径时表现出比Q-learning更“保守”的倾向。

文章评论